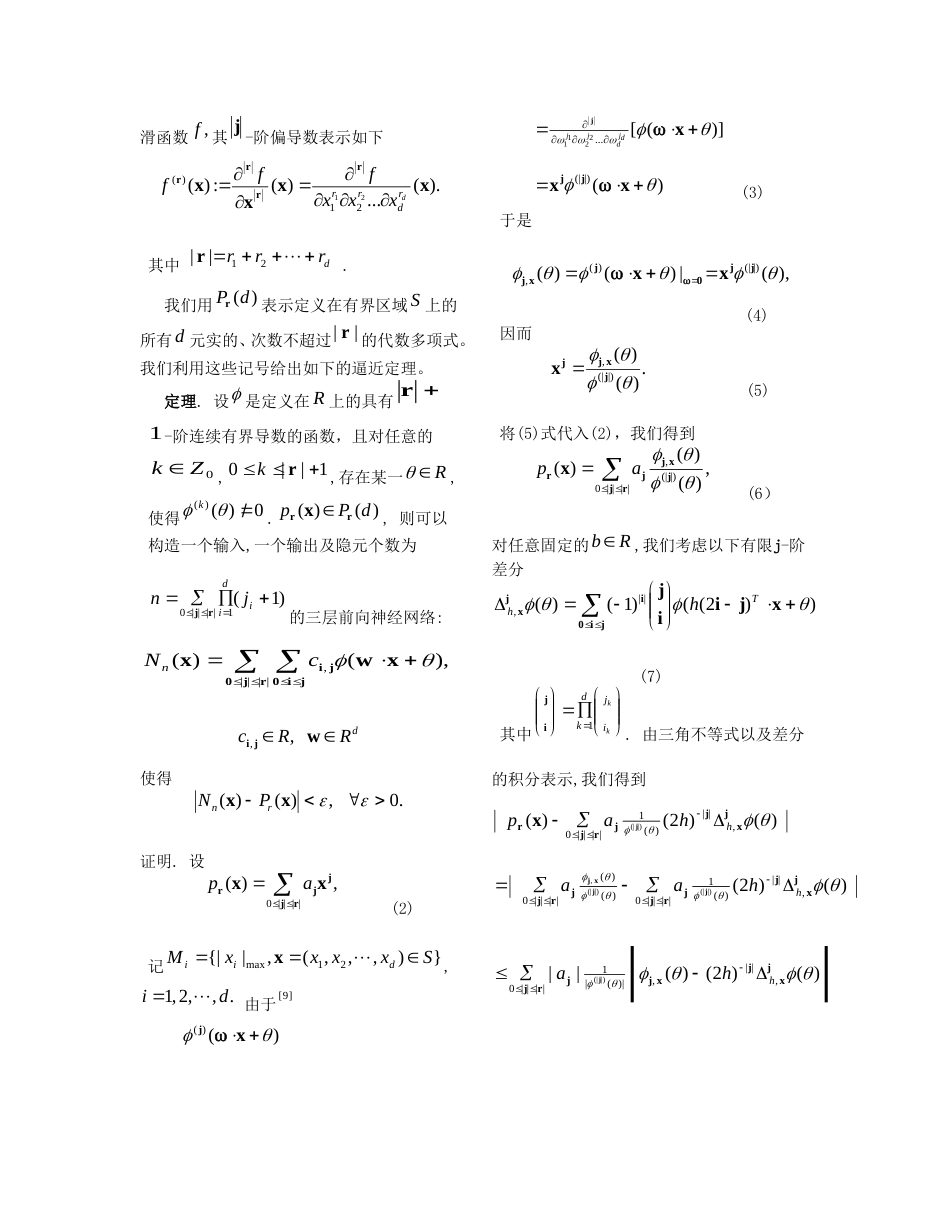

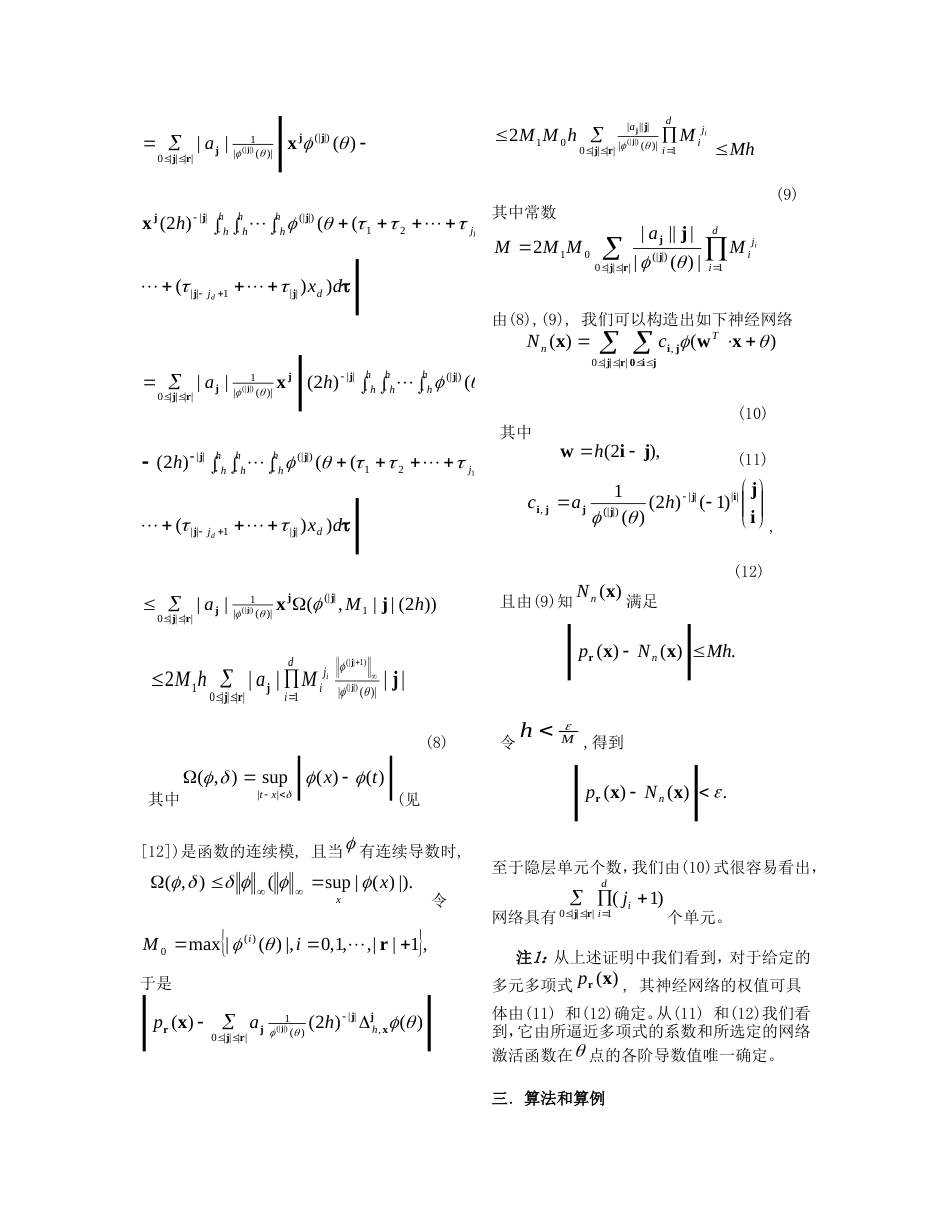

多元多项式函数的三层前向神经网络逼近方法1王建军1),2)徐宗本)2)1(西南大学数学与统计学院重庆400715))2(西安交通大学信息与系统科学研究所西安710049)摘要本文首先用构造性方法证明:对任意r阶多元多项式,存在确定权值和确定隐元个数的三层前向神经网络,它能以任意精度逼近该多项式,其中权值由所给多元多项式的系数和激活函数确定,而隐元个数由r与输入变量维数确定。我们给出算法和算例,说明基于本文所构造的神经网络可非常高效地逼近多元多项式函数。具体化到一元多项式的情形,本文结果比文献[11]所提出的网络和算法更为简单、高效;所获结果对前向神经网络逼近多元多项式函数类的网络构造以及逼近等具有重要的理论与应用意义,为神经网络逼近任意函数的网络构造的理论与方法提供了一条途径。关键词前向神经网络,多元多项式,逼近,算法中图分类号TP18ApproximationMethodofMultivariatePolynomialsbyFeedforwardNeuralNetworksWANGJian-Jun1),2)XUZong-Ben)2)1(SchoolofMathematics&Statistics,SouthwestUniversity,Chongqing400715))2(InstituteforInformationandSystemScience,Xi'anJiaotongUniversity,Xi'an710049)AbstractFirstly,thispaperinvestigatesthatforagivenmultivariatepolynomialswithrorder,athree-layerfeedforwardneuralnetworkswithdeterminateweightsandthenumberofhidden-layernodescanbeestablishedbyaconstructivemethodtoapproximatethepolynomialstoanydegreeofaccuracy.Secondly,theweightsaredecidedbyboththecoefficientsofthepolynomialsandtheactivationfunction,andthenumberofhidden-layernodesoftheconstructednetworkdependsontheorderofapproximatingpolynomialandthedimensionofinputonthenetwork..Thenwegivethealgorithmandalgorithmicexamples,wheretheconstructednetworkscanveryefficientlyapproxi-matemultivariatepolynomials.Specifically,foraunivariatepolynomial,theconstructednetworkandrealizationofalgorithmobtainedaresimplerandmoreefficientthanthoseofthereference[11].Theobtainedresultsareoftheoreticalandpracticalimportanceinconstructingafeedforwardneuralnetworkwiththree-layertoapproximatetheclassofmultivariatepolynomials.Theyalsoprovidearouteinboththeoryandmethodofconstructingneuralnetworktoapproximateanymultivariatefunctions.KeywordsFeedforwardneuralnetwork;Multivariatepolynomials;Approximation;Algorithm1本课题得到国家“973”重点基础研究发展计划项目基金(2007CB311000),国家自然科学基金重点项目(70531030),国家自然科学基金(10726040,10701062,10826081),教育部科学技术重点项目(108176),中国博士后科学基金(20080431237),西南大学博士基金(SWUB2007006)和西南大学发展基金(SWUF2007014)资助.王建军,男,1976年生,博士,副教授,主要研究方向为神经网络,学习理论和逼近论。E-mail:wjj@swu.edu.cn.徐宗本,男,1955年生,博士,教授,博士生导师,主要研究领域为人工智能,非线性泛函分析等。一.引言近年来,许多学者对神经网络逼近问题进行了研究,取得了一系列重要成果。神经网络已经在工程、计算机、物理、生物等学科中得到了广泛的应用,大多数应用都被转化为利用神经网络逼近多元函数的问题([1]-[5]等)。神经网络之所以能得到广泛应用,其主要原因之一是它具有一定意义上的万有逼近性([6],[7]等)。所有这些研究的一个典型结论是:任何一个定义在Rd上的连续函数可以通过一个具有单一隐层的三层前向神经网络任意逼近。一个具有单一隐层,含d个输入,1个输出的三层前向神经网络数学上可表示为:,1,,)(11dxwxcxdijijdjimiRN(1)其中,1imiR是阈值,,(1iiwwdTidiww)R2,...,是输入层与隐层第i个神经元的连接权值,ci是隐层与输出层之间的连接权值,是隐层节点的激活函数(传递函数)。通常情况下,网络激活函数取为sigmoid型函数,即满足1()t(t),0()t(t)的函数。用向量形式表示,(1)可进一步表达为...